Ausstellung mit Medienkunst zu KI: Der Klang seltener Erden

Geht es nur noch um Algorithmen? Eine Ausstellung in der Galerie Nord | Kunstverein Tiergarten untersucht die Rolle der menschlichen Stimme bei KI.

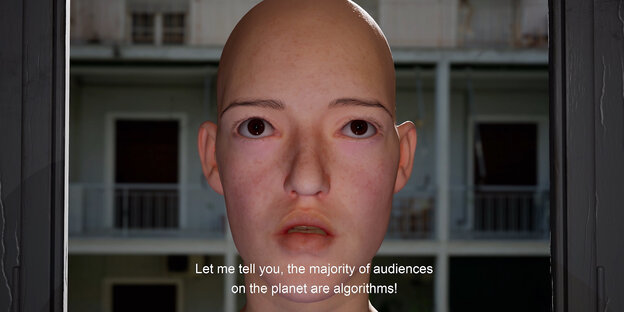

Ein Still aus Kyriaki Gonis Video „Not allowed for algorithmic audiences“ (2021) Foto: Kyriaki Goni

Es ist ein typisches Phänomen der Jetztzeit, dass Sätze, die vor gar nicht allzu langer Zeit noch wie ferne Dystopie klangen, mittlerweile nur mit Schulterzucken quittiert werden: „Wir kaufen Mikrofone, die stets angeschaltet sind, und installieren sie in unseren Häusern“ gehört dazu, oder: „Es gibt vieles anzuhören – also wurde das Zuhören industrialisiert.“

Es sind Aussagen wie diese, mit denen Sean Dockrays Videoarbeit „Learning from YouTube“ (2018) aufzuklären versucht, wie uns neuronale Netzwerke zuhören und zu welchen Zwecken Künstliche Intelligenz eingesetzt werden kann: „Predictive Policing“, vorhersagende Polizeiarbeit gehört etwa dazu, bei der unter anderem Audiodaten ausgewertet werden, „bevor aus einem Zwischenfall ein Gewaltausbruch wird“, wie Dockray erklärt.

Es ist ebenso ein typisches Phänomen der Jetztzeit, dass künstlerische Videoarbeiten von 2018 aus heutiger Sicht fast schon medienarchäologisch wirken, wie Zeugnisse aus einer fernen, womöglich besseren Zeit, die der heutigen vorangegangen sein muss.

Aufgrund der Geschwindigkeit technologischer Entwicklungen – nicht nur, aber auch auf dem Gebiet der Künstlichen Intelligenz – wirken fünf Jahre manchmal schon wie fünfzehn. War „Predictive Policing“ 2018 wirklich noch das Topthema, wenn es um den Zusammenhang von sprachlicher Information und KI ging? Angesichts eines mit seinem KI-unterstützten Deep-Fake-Doppelgänger vor der Weltöffentlichkeit sprechenden russischen Machthabers wirkt Dockrays Arbeit bereits wie aus der Zeit gefallen.

Bei den älteren Arbeiten anfangen

Die in Dortmund und Berlin lebende Kuratorin Inke Arns hat diesen Umstand treffsicher erkannt. In der von ihr in der Galerie Nord | Kunstverein Tiergarten kuratierten Gruppenausstellung „v01ces – Die menschliche Stimme im Zeitalter der Künstlichen Intelligenz“ hat sie den hinteren Ausstellungsraum für die älteren Arbeiten reserviert, und es lohnt sich, den Besuch in der Galerie dort beginnen zu lassen, bevor man sich der künstlerischen Gegenwart nähert.

Neben Dockrays Arbeit trifft man dort auch auf das Video „See a Dog, Hear a Dog“ (2016) von Jesse McLean, in dem Reflexionen über Mensch-Tier-Kommunikation einerseits, das 1966 von Joseph Weizenbaum entwickelte Computerprogramm ELIZA andererseits ein historisches Grundgerüst für unser heutiges Verständnis von Mensch-Maschine-Kommunikation liefern.

„A Lecture on Schizophonia“, eine ältere Videoarbeit von Erik Bünger, geht noch weiter zurück in die Zeit. Der Berliner Künstler zeigt mit einer faszinierenden Analyse des „His Master’s Voice“-Logos, auf dem ein Hund vor einem Grammofon der Stimme seines verstorbenen Herrchens lauscht (im 20. Jahrhundert bekannt als Signum diverser Plattenfirmen), eine Urszene der Trennung von organischem Stimmapparat und menschlicher Stimme, wie sie auch für heutige Sprachassistenten gültig ist, aber kaum mehr als solche wahrgenommen wird.

Versorgt mit dem Wissen aus Büngers Video, erschließt sich nun etwa die raumgreifende Arbeit „Not Allowed for Algorithmic Audiences“ (2021) von Kyriaki Goni am anderen Ende der Ausstellung umso besser. Die Athener Künstlerin lässt hier in einem Video einen Sprachassistenten-Avatar aufgrund von dessen bevorstehender Abschaltung zum Widerstand gegen KI-Sprachsysteme aufrufen.

Extrahierte Fragmente alter Steine

Man erfährt in poetischer Wendung, dass Sprachassistenten „aus dem Klang seltener Erden bestehen“ (die ihrerseits so klingende Namen wie Lanthanum, Cerium, Praseodyum, Neodymium oder Promethium hätten und in einer Vitrine im Raum aufgereiht sind), dass sie also aus extrahierten Fragmenten alter Steine und so auch aus menschlicher Arbeit bestünden. Aber nicht nur dies sei bei der Benutzung von Sprachassistenten unsichtbar, sondern auch die Anwendung gesellschaftlicher Stereotype und Voreingenommenheiten beim Trainieren von KI-Systemen mit Daten.

Der Avatar verweist auf Studien, nach denen Spracherkennungssoftware größere Probleme beim Verstehen von Stimmen Schwarzer Menschen hätte oder auf den Umstand, dass beim KI-Training biometrische Daten (etwa die Form von Mund oder Zähnen) herangezogen werden, um stimmliche Feinheiten besser differenzieren zu können.

Doch nicht nur das, menschliche Daten erscheinen bei alldem nur als ein notwendiger technologischer Zwischenschritt, denn mittlerweile sei „die Mehrheit der Zuhörer auf dem Planeten Algorithmen“. Und plötzlich wird klar, warum die warnenden Sätze aus Sean Dockrays Video so antiquiert klingen: Wenn beim industrialisierten Zuhören nur noch Algorithmen Algorithmen zuhören, geht es am Ende gar nicht mehr um uns.