Dokumentarfilm „Coded Bias“: Einäugige Maschinen

Menschen können rassistisch und sexistisch sein – so wie die Algorithmen, die uns das Leben erleichtern: Die Hamburger W3 zeigt die Doku „Coded Bias“.

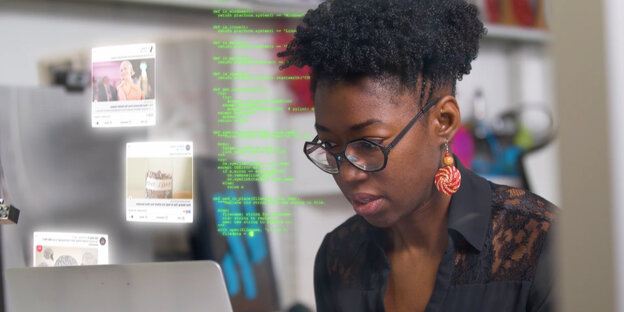

Zweifelt an der Neutralität der Künstlichen Intelligenz: Joy Buolamwini Foto: 7th Empire Media

HAMBURG taz | Eigentlich hatte Joy Buolamwini einen Spiegel erfinden wollen, der Hineinblickende aufmuntert, indem er das gespiegelte Gesicht etwa mit dem einer Lieblingssängerin oder auch eines mutmachenden Löwen kombiniert – mittels Webcam und Gesichtserkennungssoftware. Dabei stieß die Computerwissenschaftlerin auf ein Problem: Keine ausprobierte Software erkannte zuverlässig Buolamwinis Gesicht. Die Programme, entwickelt in den Laboren von Google, Amazon oder Microsoft, identifizierten zuverlässig weiße Männer-, aber nicht schwarze oder Frauengesichter.

Eigentlich ganz gut für nicht weiße, nicht männliche Menschen – nicht erkannt zu werden etwa von den vielen Kameras im öffentlichen Raum in einer Stadt wie London. Oder nicht? Kommt darauf an, auch das zeigt Shalini Kantayyas in den USA, England und China entstandene Doku „Coded Bias“, die am Dienstagabend die Hamburger W3 streamt: Da beobachten Aktivist*innen der britischen NGO „Big Brother Watch“, wie ein Mann sich weigert, sein Gesicht in eine Polizeikamera zu halten, und dafür eine Strafe zahlen soll; dass er ein Recht an seinen biometrischen Daten habe, mögen die Beamt*innen nicht erkennen.

Dass sie damit im Recht sein könnten, ist Teil des Problems. Anders als bei der eigenen DNA oder dem, was so alles im Pass steht, ist vielerorts schlicht nicht geregelt, was der Staat mit aufgezeichneten Gesichtern machen darf – gegenüber den einschlägigen Tech-Riesen willigen die Nutzer*innen ja wenigstens noch so was wie ein in die jeweils irgendwo in den AGB versteckte Klausel. Anders in China, lernen wir: Da müsse, wer das Internet nutzen will, der Gesichtserkennung zustimmen – und der Verarbeitung durch den Staat.

Und im US-Staat Massachusetts soll eine Software der gestressten Justiz helfen: Sie ermittelt die Rückfallwahrscheinlichkeit von Angeklagten, und das eben wiederum erkennbar entlang den Linien von – Hautfarbe und Herkunft. Und längst durchgesetzt haben sich entsprechende Werkzeuge vielerorts auf der Welt bei Job- oder Kreditvergabe oder der Risikoberechnung in den entsprechenden Abteilungen der Versicherungen.

Coded Bias, USA/UK/CN 2020, Regie: Shalini Kantayya, 85 Min.

Online-Screening (OmU): Di, 11. 5., 18 Uhr, https://w3-hamburg.de/veranstaltung/coded-bias/; anschließend diskutieren

- Francesca Schmidt (Gunda-Werner-Institut),

- Matthias Spielkamp (Algorithm Watch) und

- Viktor Schlüter (Amnesty International).

Anmeldung: info@w3-hamburg.de

Aber jedes System, so muss angenommen werden, in dem ausreichend hoher Spardruck aufkommt, dürfte anfällig sein für die so viel schnelleren, zuverlässigeren und unterstellt neutraleren Maschinenlösungen: Wo Algorithmen heute schon stapelweise Röntgen- respektive MCT-Bilder auf Auffälligkeiten hin sichten: Warum sollte Kollege KI dann nicht auch bessere, mindestens aber schnellere Entscheidungen treffen, wenn es darum geht, wer ein gespendetes Organ bekommt?

Den Neutralitätsaspekt aber bestreiten, ja: widerlegen etliche der Aktivist*innen, die in dem gelungenen Film auftretend: Die lernende Maschine mag nicht böse sein, aber sie ist auch nicht weniger anfällig für Vorurteile, als es die Menschen sind, die sie ins Werk setzen.