Überwachung im Knast: Wenn die Maschine entscheidet

Die niedersächsischen Fraktionen der SPD und CDU wollen Inhaftierte in ihren Zellen überwachen – basierend auf künstlicher Intelligenz.

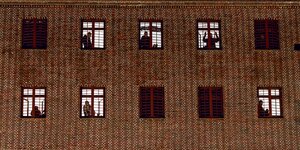

Sollen zukünftig „intelligent“ überwachen: Kameras am Knast Foto: Marcel Kusch/dpa

HAMBURG taz | Wenn Inhaftierte live per Video überwacht werden, ohne dass ein*e Mitarbeiter*in der Justizvollzugsanstalt vor dem Bildschirm sitzen muss – da werden Überwachungsträume wahr. Jedenfalls träumen die niedersächsischen Landtagsfraktionen von SPD und CDU von auf künstlicher Intelligenz (KI) basierter Videoüberwachung in Knästen. Und arbeiten daran, diese Fantasien zur Realität werden zu lassen: In der Landtagssitzung am Mittwoch wollen die Fraktionen beantragen, die Gesetzesgrundlage für ein entsprechendes Modellprojekt zu schaffen.

„Wir müssen endlich die vielfältigen Möglichkeiten der Digitalisierung, speziell der künstlichen Intelligenz, in allen Bereichen der Sicherheitspolitik nutzen“, sagt der rechtspolitische Sprecher der CDU-Fraktion, Christian Calderone.

Er argumentiert mit Suizidprävention und der allgemeinen Erhöhung der Sicherheit im Knast. „Intelligente“ Videoüberwachungsanlagen könnten etwa suizidgefährdete Personen in ihren Zellen beobachten und Alarm schlagen, sobald sie auffällige Verhaltensweisen erkennen. Bislang müssen echte Menschen in regelmäßigen Abständen die Zellentür aufschließen, um zu gucken, ob jemand noch lebt. Kameras in Zellen gibt es nur in Ausnahmefällen.

Aber auch außerhalb der Zellen, bei sogenannten Freistunden, könnten die „intelligenten“ Kameras Bewegungen und Verhalten der Gefangenen analysieren und zum Beispiel die Übergabe von Schmuggelware oder sich anbahnende körperliche Auseinandersetzungen erkennen.

Datenschutzrechtlich bedenklich

Projekte, in denen eine solche „intelligente“ Überwachung erprobt wird, gibt es etwa am Berliner Bahnhof Südkreuz oder auf dem Mannheimer Bahnhofsvorplatz. „Die Entwicklungsfortschritte bei der künstlichen Intelligenz sind gigantisch“, schwärmt Calderone.

Tatsächlich verliefen die Testphasen für die Gesichts- und Verhaltenserkennung am Südkreuz gelinde gesagt eher mäßig. Der Chaos Computer Club bezeichnete den Abschlussbericht der ersten Testphase als „unwissenschaftlich“ und als „Debakel“. Die Berliner Datenschutzbeauftragte kritisierte die extrem hohe Fehlerquote.

Auch Michael Ebeling von der Nichtregierungsorganisation „Freiheitsfoo“ findet solche als intelligent bezeichneten Überwachungstechnologien bedenklich. „Überall, wo im großen Stil biometrische Daten gesammelt und identitätsbezogen verarbeitet werden, besteht die Gefahr des Missbrauchs“, sagt er. Auch wenn die KI „lerne“, berge das Gefahren: Am Ende verstünden die Menschen, die sie benutzten, oft gar nicht, nach welchen Parametern sie reagiere.

CDU und SPD hingegen sehen datenschutzrechtlich einen Fortschritt in dem Projekt. „Intelligente Überwachungssysteme zur frühzeitigen Erkennung von Gefahrenlagen greifen weniger stark in das Grundrecht auf informationelle Selbstbestimmung ein als herkömmliche Überwachungsanlagen“, schreiben sie in dem Antrag.

Es geht auch um Entlastung der Justizbeamten

Die SPD-Abgeordnete und rechtspolitische Sprecherin Wiebke Osigus erklärt, es gehe zunächst darum, überhaupt die Rechtsgrundlage für die Nutzung von KI-Überwachungstechnologien zu schaffen. Wie eine Nutzung dann aussehen würde, müsste man im nächsten Schritt aushandeln. Etwa, ob ein externes Unternehmen mit dem Betreiben der Software beauftragt und wo die Daten gespeichert würden. Das Ganze soll als ein Aspekt einer umfassenden Novelle in das Justizvollzugsgesetz einfließen und noch vor der Sommerpause im Landtag zur Diskussion gestellt werden.

„Die Idee ist auch, die Vollzugsbeamt*innen zu entlasten und die Fehlerquote zu minimieren“, sagt Osigus. Wer viele Stunden lang auf einen Bildschirm starre, reagiere möglicherweise nicht so schnell auf ungewöhnliches Verhalten der überwachten Person wie eine KI-basierte Anlage, die innerhalb von Sekundenbruchteilen Alarm schlagen könnte.

„Bei der kompletten Entrechtung, die Menschen im Knast erfahren, gibt es viel zu wenig psychologisches Personal“

Aber was ist ungewöhnliches Verhalten? Dass eine Maschine das entscheiden soll, sieht Ebeling von Freiheitsfoo kritisch. „Gerade bei digitalisierter Verhaltenserkennung ist immer die Frage, von welcher Norm man ausgeht“, sagt er. „Personen, die nicht einem bestimmten Schema entsprechen, das oft relativ unseriös und unwissenschaftlich festgelegt wird, geraten schnell in den Fokus.“ Wer Menschen einsperre, müsse auch dafür sorgen, dass genug Ressourcen bereitstünden, sich um sie zu kümmern, das könne man nicht Maschinen überlassen.

Ähnliche Bedenken äußert der sozialpolitische Sprecher der im Landtag oppositionellen Grünen, Volker Bajus. „Für Suizid-Prävention braucht es eine gute sozial-psychologische Betreuung. Das kann man nicht mit dem Verweis auf moderne Technik wegdiskutieren“, sagt er.

Für Britta Rabe vom Grundrechtekomitee zeigt sich bei der Debatte ein grundsätzliches Problem. „Bei der kompletten Entrechtung, die Menschen im Knast erfahren, gibt es viel zu wenig psychologisches Personal.“ Es stelle sich zudem die Frage, ob suizidgefährdete Menschen überhaupt in Haft sein müssten. Wenn man sich schon dafür entscheide, würde es zumindest der bessere präventive Ansatz sein, statt weniger menschliche Begegnungen zu ermöglichen.

Leser*innenkommentare

Andreas_2020

Der Punkt ist doch, dass dieses Ansinnen entblößt, dass in Gefängnissen eine interne Ordnung unter den Gefangenen besteht und ein Gefängnisdirektor diese besser beachtet, sonst drohen ihm Probleme. In fast allen Gefängnissen finden Schlägereien, Vergewaltigungen, Schwarzmarkt, Erpressung, Bedrohung und verbale Beleidigungen statt. Das wird sich mit solchen Kameras nicht aufhalten lassen, es wird eher problematischer, weil dann Dinge bekannt werden, die besser nicht bekannt werden sollten, deswegen halte ich das für eine Ente und von wegen Entlastung der Beamten ... das wird den Stress erhöhen, weil der Druck auf das System gewaltig gesteigert wird, die Knast-Hierarchien schaffen ja eine Ordnung, minimieren Konflikte zwischen den JVA-Beamten und den Insassen. Bricht man dies auf und lässt dort andere Machtverhältnisse entstehen, gilt es diese, wieder zu bändigen. Der eigentliche Punkt ist doch, dass in Gefängnissen die Uhren still stehen. Seit den frühen 70er Jahren hat sich nur wenig getan, jedenfalls an der Grundstruktur. Interesse aus der Politik gibt es auch kaum, ich glaube, dass es wahrscheinlicher ist, dass ein Roboter sich mit den Beschwerdebriefen aus den JVAs beschäftigen wird, als dass diese Instrumente auf breiter Flur eingesetzt werden. Schon alleine Fragen der Menschenwürde und des Datenschutzes kommen auf, nicht nur der Insassen, sondern auch der Beamten und Kräfte, die dort arbeiten.